Le contexte : une équipe créée pour incarner la mission originelle

En septembre 2024, OpenAI lançait son équipe Mission Alignment. Composée d’une petite dizaine de personnes, elle avait pour objectif clair de communiquer et promouvoir la mission fondatrice de l’entreprise : s’assurer que l’intelligence artificielle générale (AGI) bénéficie à toute l’humanité. À une époque où l’entreprise passait d’une structure non lucrative à un modèle plus orienté profits, cette équipe servait de pont entre les idéaux initiaux et la réalité opérationnelle d’une scale-up en hyper-croissance.

Dirigée par Josh Achiam, un vétéran de la recherche en sécurité IA chez OpenAI depuis plus de huit ans, l’équipe travaillait à la fois en interne (sensibilisation des employés) et en externe (dialogue avec le public, régulateurs et médias). Dans un monde où les entreprises tech sont scrutées sur leur impact sociétal, une telle structure représentait un atout en termes de personal branding corporate et de gestion de réputation.

Le projet Mission Alignment était une fonction de support pour aider les employés et le public à comprendre notre mission et l’impact de l’IA. Ce travail se poursuit à travers toute l’organisation.

– Porte-parole d’OpenAI

Cette déclaration officielle minimise l’événement en le présentant comme une simple réorganisation. Pourtant, dans le contexte des bouleversements récurrents chez OpenAI (départs de figures clés, restructurations, pivot vers le profit), elle interpelle.

Les faits : dissolution et réaffectation rapide

En février 2026, l’équipe est dissoute. Ses 6 à 7 membres sont réaffectés dans d’autres départements. Josh Achiam, le leader, ne disparaît pas : il est promu au poste inédit de Chief Futurist. Dans un billet publié sur Substack, il explique sa nouvelle mission :

Mon objectif est de soutenir la mission d’OpenAI — garantir que l’intelligence artificielle générale bénéficie à toute l’humanité — en étudiant comment le monde va changer face à l’IA, l’AGI et au-delà.

– Josh Achiam, Chief Futurist chez OpenAI

Il mentionne une collaboration avec Jason Pruet, physicien chez OpenAI. Cette réorientation vers une vision prospective semble élégante, mais elle soulève des interrogations : est-ce une promotion symbolique ou une dilution des efforts concrets sur l’alignement et la sécurité ?

Pour les startups IA qui cherchent à se différencier, ce genre de signal peut influencer les choix de partenaires, de financements ou même de positionnement marketing. Une entreprise qui met en avant sa mission éthique peut gagner en trust auprès des clients B2B sensibles à ces sujets.

Un pattern récurrent chez OpenAI : la fin des équipes dédiées à la sécurité ?

Ce n’est pas la première fois. En 2023, OpenAI créait la fameuse équipe Superalignment, dédiée aux risques existentiels de l’AGI. Elle fut dissoute en 2024. Aujourd’hui, c’est au tour de Mission Alignment. Ces suppressions successives font écho à d’autres évolutions :

- Suppression du mot « safely » dans la mission officielle (observée dans les documents fiscaux récents).

- Passage à un modèle plus lucratif avec des investissements massifs.

- Départs de figures historiques attachées à la sécurité (comme certains chercheurs en 2024).

Ces changements traduisent une priorisation accrue sur la vitesse de développement, les revenus (via ChatGPT Enterprise, API, etc.) et la concurrence féroce avec Anthropic, Google, Meta ou xAI. Pour les entrepreneurs, cela rappelle une leçon clé : dans la tech, les missions originelles peuvent évoluer rapidement sous la pression du marché.

Quelles implications pour le marketing et le branding des startups IA ?

Dans un marché saturé d’outils IA, la différenciation ne passe plus seulement par la performance technique. La perception éthique devient un levier marketing puissant. Voici pourquoi la dissolution de cette équipe chez OpenAI peut servir de cas d’école :

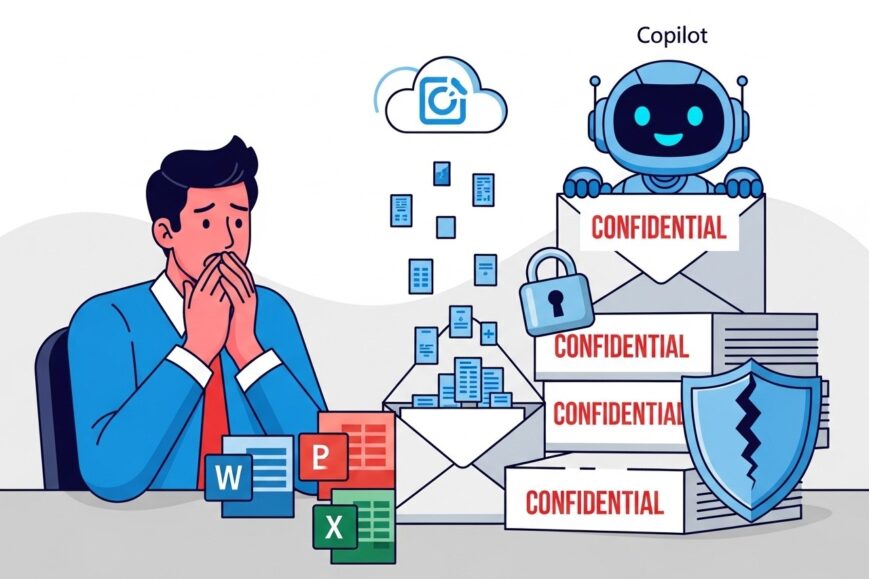

- Confiance utilisateur : Les clients B2B (entreprises, agences) exigent de plus en plus de transparence sur l’alignement éthique et la gestion des risques. Une startup qui communique clairement sur ses garde-fous peut transformer cela en argument de vente.

- Positionnement premium : Les solutions « safe by design » attirent les secteurs réglementés (santé, finance, éducation). OpenAI perd peut-être un avantage concurrentiel en diluant cet aspect.

- Gestion de crise : Quand des incidents surviennent (biais, hallucinations, fuites de données), les entreprises sans discours fort sur la mission risquent un bad buzz amplifié sur les réseaux.

- Attractivité talents : Les meilleurs chercheurs en IA veulent souvent travailler sur des projets alignés avec des valeurs fortes. Une dilution visible peut compliquer le recrutement.

Pour les marketeurs, l’exemple OpenAI montre qu’il faut aligner communication externe et réalité interne. Une mission affichée sans structure dédiée peut vite sembler creuse.

Le rôle du Chief Futurist : gadget ou vraie évolution stratégique ?

Le nouveau titre de Josh Achiam intrigue. Chief Futurist évoque une posture visionnaire, prospective. Dans les grandes entreprises tech, ce type de rôle existe parfois (chez Google, Microsoft, etc.) pour anticiper les disruptions sociétales, réglementaires ou culturelles liées à leurs technologies.

Avantages potentiels pour OpenAI :

- Anticiper les scénarios post-AGI pour adapter produits et communication.

- Renforcer l’image d’entreprise qui « pense long terme ».

- Dialoguer avec gouvernements, think tanks et ONG sur les impacts futurs.

Mais sans équipe dédiée, sans budget clair ni pouvoir décisionnel visible, ce rôle risque de rester symbolique. Pour les startups, cela pose une question : faut-il investir dans des postes « visionnaires » ou privilégier des équipes opérationnelles sur la compliance et l’éthique ?

Ce que les entrepreneurs et marketeurs doivent retenir

L’histoire récente d’OpenAI est riche d’enseignements pour quiconque construit une startup dans l’IA ou le deep tech :

- La mission est un actif stratégique : elle influence le recrutement, les partenariats, les levées de fonds et la fidélisation client. La diluer sans communication claire peut coûter cher en réputation.

- L’équilibre profit / impact évolue vite : les investisseurs exigent du ROI, mais les utilisateurs et régulateurs demandent de la responsabilité. Trouver le bon mix est un exercice permanent.

- La transparence paie : communiquer ouvertement sur les choix organisationnels (même difficiles) renforce la crédibilité.

- Anticiper les narratives : le récit autour de l’IA oscille entre utopie et dystopie. Les entreprises qui maîtrisent leur narration gagnent en influence.

Dans un marché où l’IA est devenue omniprésente, les différenciateurs durables passent par l’éthique, la gouvernance et la capacité à raconter une histoire cohérente.

Vers un futur où l’alignement devient un argument business ?

Si OpenAI choisit de déprioriser les structures dédiées à l’alignement au profit de la vitesse et du chiffre d’affaires, d’autres acteurs pourraient occuper cet espace. Anthropic, avec son positionnement très fort sur la sécurité, en est un exemple. Des startups européennes ou open-source pourraient aussi capitaliser sur ce créneau en se présentant comme les « alternatives responsables ».

Pour les marketeurs et fondateurs, l’opportunité est là : transformer l’alignement et la responsabilité en véritables USP (Unique Selling Proposition). Cela passe par :

- Des audits éthiques publiés.

- Des roadmaps claires sur la sécurité.

- Des contenus éducatifs sur les impacts de l’IA.

- Des partenariats avec des ONG ou chercheurs indépendants.

En conclusion, la dissolution de l’équipe Mission Alignment chez OpenAI n’est pas un simple ajustement organisationnel. C’est un symptôme d’une tension plus large dans l’industrie : celle entre la course à l’AGI et la nécessité de préserver la confiance sociétale. Pour les acteurs du marketing, des startups et du business tech, c’est une invitation à réfléchir : comment faire de l’éthique non pas une contrainte, mais un levier de croissance et de différenciation durable ?