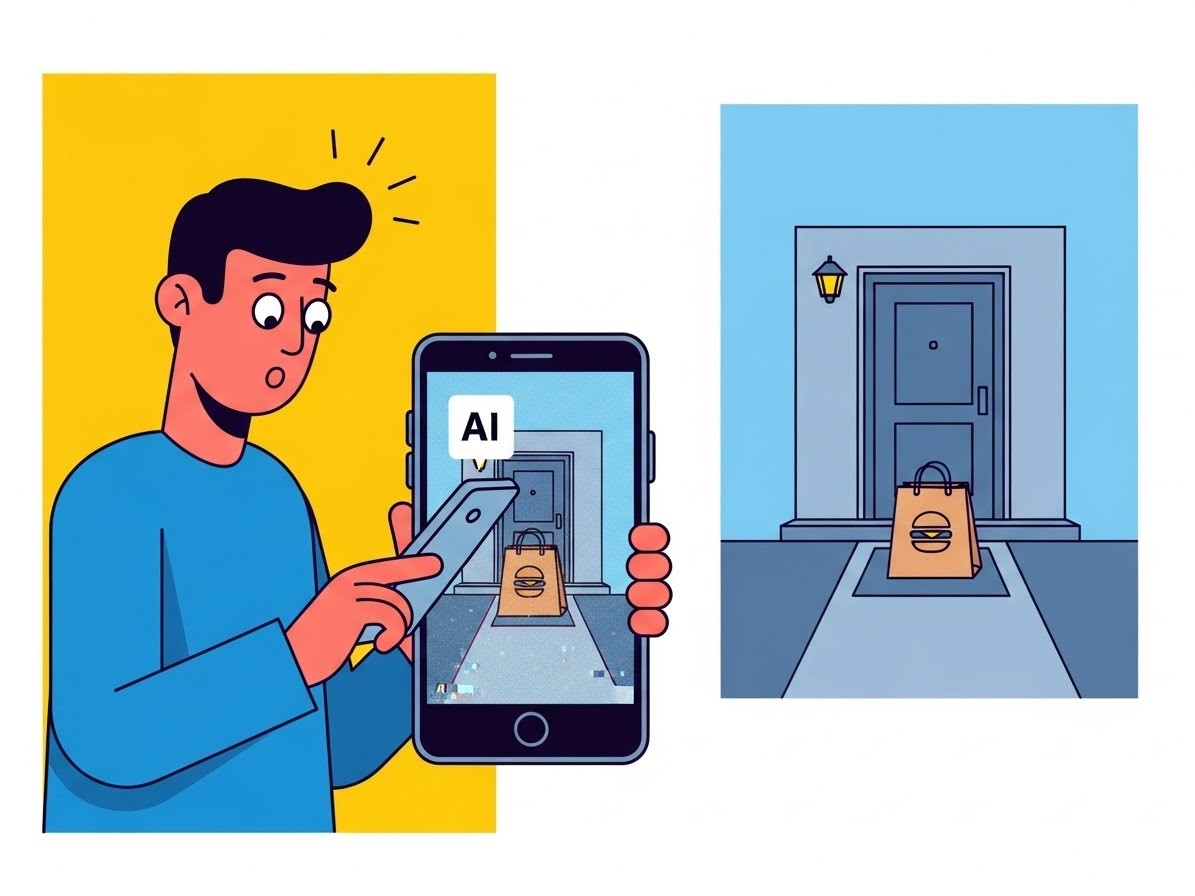

Imaginez commander votre repas préféré un soir de décembre, attendre avec impatience, puis recevoir une notification : « Livraison effectuée ». Vous ouvrez la porte… et rien. Pas de sac, pas de nourriture. À la place, une photo jointe montre votre commande posée devant chez vous. Sauf que l’image semble trop parfaite, presque irréelle. C’est exactement ce qui est arrivé à un habitant d’Austin, et le coupable ? Une intelligence artificielle utilisée pour tromper la plateforme DoorDash.

Cette histoire, devenue virale fin 2025, met en lumière un phénomène inquiétant : l’utilisation malveillante des outils d’IA générative dans l’économie des plateformes. Pour les entrepreneurs, startups et professionnels du digital que vous êtes, cela soulève des questions cruciales sur la confiance, la sécurité et l’avenir des modèles économiques basés sur la gig economy.

Que s’est-il réellement passé chez DoorDash ?

L’incident remonte à décembre 2025. Byrne Hobart, un résident d’Austin connu sur X pour ses analyses pointues en finance et technologie, partage un post qui fait rapidement le tour du web. Il explique avoir commandé via DoorDash, vu son livreur accepter la course, marquer immédiatement la livraison comme terminée, puis recevoir une photo preuve… manifestement générée par IA.

En comparant l’image fournie par le livreur avec une photo réelle de son entrée, les différences sautent aux yeux : ombres incohérentes, textures trop lisses, détails architecturaux légèrement déformés. Des signes classiques d’une génération par un modèle comme Midjourney ou DALL-E.

« Amazing. DoorDash driver accepted the drive, immediately marked it as delivered, and submitted an AI-generated image of a DoorDash order (left) at our front door (right). »

– Byrne Hobart, sur X

Ce qui rend l’affaire encore plus crédible, c’est qu’un autre utilisateur d’Austin rapporte exactement la même expérience avec le même nom de livreur affiché. Coïncidence ? Peu probable.

Comment une telle fraude est-elle techniquement possible ?

Pour comprendre le mécanisme, il faut plonger dans les fonctionnalités mêmes des applications de livraison. DoorDash, comme ses concurrents, montre parfois aux livreurs des photos des lieux de livraison issues de commandes précédentes. Cela aide à localiser précisément l’adresse.

Le livreur malveillant aurait donc pu :

- Capturer ou récupérer une photo réelle du pas de porte via l’historique de l’application.

- Utiliser un outil d’IA générative (accessible même sur smartphone via des apps ou des comptes piratés) pour superposer numériquement un sac DoorDash rouge sur cette photo.

- Soumettre cette image falsifiée comme preuve de livraison.

- Encaisser la rémunération sans jamais se déplacer.

Une opération qui prendrait moins de deux minutes avec les outils actuels. Effrayant, non ?

Byrne Hobart émet l’hypothèse d’un compte piraté ou d’un téléphone jailbreaké pour contourner d’éventuelles restrictions. Quoi qu’il en soit, cela démontre à quel point les barrières à l’entrée pour ce type de fraude sont basses.

La réponse rapide de DoorDash

Face à la viralité du post, DoorDash n’a pas traîné. Un porte-parole a confirmé à TechCrunch une enquête immédiate, aboutissant à la désactivation permanente du compte du livreur concerné et au remboursement intégral du client.

« Nous avons zéro tolérance pour la fraude et utilisons une combinaison de technologie et de revue humaine pour détecter et empêcher les mauvais acteurs d’abuser de notre plateforme. »

– Porte-parole DoorDash

Une réaction exemplaire en termes de communication de crise. Mais elle soulève aussi la question : comment une telle fraude a-t-elle pu passer les filtres initiaux ?

Les failles actuelles des systèmes de détection

La plupart des plateformes de livraison s’appuient sur plusieurs couches de vérification :

- Géolocalisation GPS du livreur.

- Photo obligatoire de la livraison.

- Algorithmes de détection d’anomalies (temps trop court, distance suspecte).

Mais ces systèmes montrent leurs limites face à l’IA générative. Une photo falsifiée peut contourner la vérification humaine si le volume est élevé, et les détecteurs automatiques d’images IA ne sont pas encore généralisés à grande échelle.

En 2026, on estime que plus de 90 % des contenus visuels en ligne pourraient contenir des éléments générés par IA (source : rapports universitaires sur la prolifération des deepfakes). Les plateformes doivent donc accélérer leur course à l’armement technologique.

Les implications business pour les plateformes gig economy

Pour les startups et scale-ups du secteur (Uber Eats, Deliveroo, Just Eat, etc.), cette affaire est un signal d’alarme. La confiance est le socle de leur modèle économique. Un seul incident viral peut entacher des années de construction de marque.

Les coûts directs sont aussi significatifs :

- Remboursements massifs en cas de fraudes répétées.

- Augmentation des primes d’assurance.

- Investissements lourds en R&D pour des systèmes de détection plus robustes.

- Perte de partenaires restaurants si la fiabilité baisse.

À plus long terme, cela pourrait pousser vers une ré-internalisation de certaines flottes de livreurs, comme Amazon l’a fait avec Flex, au détriment du modèle 100 % indépendant.

L’IA générative : une arme à double tranchant pour les entrepreneurs

Si cette histoire illustre le côté sombre, rappelons que l’IA générative offre aussi d’immenses opportunités dans le delivery et l’e-commerce :

- Optimisation des tournées via des algorithmes prédictifs.

- Personnalisation des recommandations produits.

- Chatbots ultra-réalistes pour le service client.

- Génération automatique de visuels marketing pour les restaurants partenaires.

Le défi pour vous, entrepreneurs et marketeurs, est d’exploiter ces outils tout en mettant en place des garde-fous éthiques et techniques.

Quelles solutions techniques pour contrer ces fraudes ?

Plusieurs pistes émergent déjà en 2026 :

- Détecteurs d’images IA intégrés : outils comme Hive Moderation ou Truepic pour authentifier les photos en temps réel.

- Vérification par watermarking invisible : ajout de métadonnées cryptées lors de la prise de photo via l’app.

- Live video proof : obligation de filmer quelques secondes la pose du sac (testé par certaines plateformes asiatiques).

- Analyse comportementale avancée : croisement GPS, accéléromètre, temps de trajet réaliste.

- IA contre IA : modèles entraînés spécifiquement pour repérer les artefacts de génération.

Les startups spécialisées dans la trust & safety (comme Sift ou Forter) voient leur marché exploser. Une opportunité pour les investisseurs du secteur.

Impact sur la perception publique de l’IA

Cette affaire DoorDash s’ajoute à une liste croissante d’abus : deepfakes politiques, arnaques vocales, faux avis générés. Elle alimente le débat sur la régulation de l’IA générative.

Pour les professionnels du marketing digital, cela signifie une nécessité accrue de transparence. Mentionner l’usage d’IA dans les campagnes devient non seulement éthique, mais stratégique pour maintenir la confiance des consommateurs.

Leçons à retenir pour votre business

Que vous dirigiez une startup SaaS, une agence digitale ou une plateforme e-commerce, voici les enseignements clés :

- Anticipez les usages malveillants des technologies que vous intégrez.

- Investissez tôt dans des systèmes de vérification robustes.

- Communiquez rapidement et clairement en cas d’incident.

- Formez vos équipes à l’éthique IA.

- Surveillez les tendances frauduleuses sur les réseaux comme X ou Reddit.

L’histoire de ce livreur fraudeur n’est probablement que la partie visible de l’iceberg. En 2026, l’IA générative est partout, et avec elle, de nouvelles formes de criminalité numérique.

Mais pour les entrepreneurs avertis, c’est aussi l’occasion de se différencier en construisant des plateformes plus sûres, plus transparentes. La confiance reste le meilleur avantage concurrentiel dans un monde où tout peut être falsifié.

Et vous, avez-vous déjà été confronté à des fraudes liées à l’IA dans votre activité ? Partagez vos expériences en commentaire, elles pourraient aider la communauté à mieux se préparer.