-

Marc Andreessen Critique les Universités sur le DEI

Et si les universités, piliers de l’innovation, devenaient des freins au progrès technologique ? Cette question, provocatrice, est au cœur d’une récente polémique impliquant Marc Andreessen, figure emblématique du capital-risque et co-fondateur d’Andreessen Horowitz. Dans un échange privé relayé par le Washington Post, l’investisseur légendaire aurait critiqué des institutions prestigieuses comme Stanford et MIT, les […] -

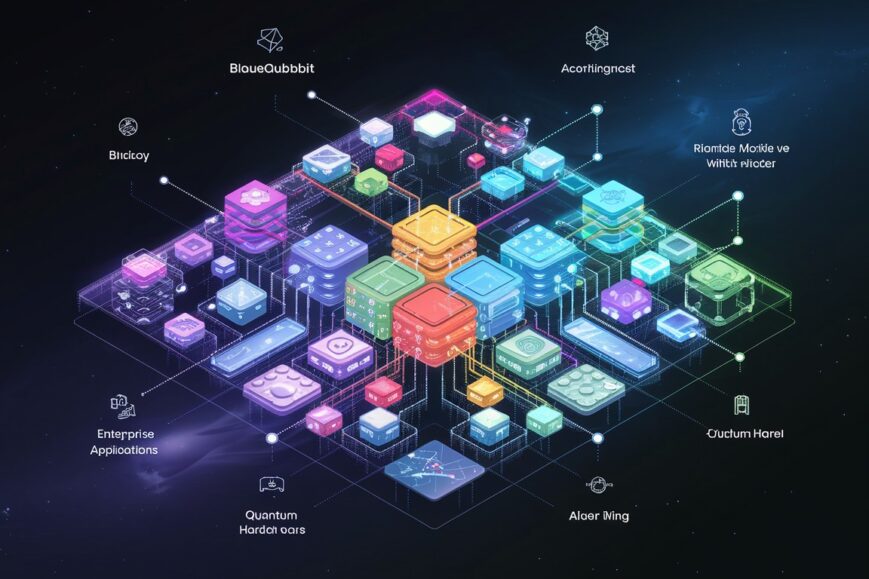

BlueQubit Lève 10 Millions pour Démocratiser l’Informatique Quantique

L’informatique quantique suscite un intérêt croissant ces dernières années, promettant de repousser les limites du possible dans de nombreux domaines comme la finance, la pharmaceutique ou la science des matériaux. Cependant, intégrer le calcul quantique dans des applications informatiques concrètes reste un défi majeur, les plateformes quantiques étant architecturées de manière fondamentalement différente des ordinateurs […] -

Les Modèles TTT : Une Nouvelle Frontière Pour l’IA Générative

Imaginez un modèle d’IA capable de traiter des milliards de données, des mots aux vidéos, sans consommer une quantité astronomique d’énergie. C’est la promesse des modèles TTT (Test-Time Training), une architecture innovante développée par des chercheurs de Stanford, UC San Diego, UC Berkeley et Meta. Pourraient-ils sonner le glas des transformateurs, omniprésents dans l’IA générative […]