Imaginez un instant : chaque jour, des dizaines de milliards de requêtes automatisées frappent les serveurs du monde entier. Parmi elles, certaines viennent chercher votre contenu pour l’indexer dans Google, d’autres pour nourrir des modèles d’intelligence artificielle, et d’autres encore pour répondre instantanément à la question d’un utilisateur via un chatbot. Une étude récente, d’une ampleur inédite, a scruté pas moins de 66,7 milliards de ces requêtes sur plus de 5 millions de sites. Le verdict ? Le web tel que nous le connaissions est en pleine mutation silencieuse, et les règles de visibilité changent radicalement en 2026.

Pour les marketeurs, les fondateurs de startups et les créateurs de contenu, cette transformation n’est pas une simple anecdote technique. Elle redéfinit où et comment capter l’attention, générer du trafic et conserver une maîtrise sur sa présence numérique. Plongeons ensemble dans les enseignements majeurs de cette analyse massive et voyons concrètement ce que vous pouvez en tirer pour votre stratégie digitale.

Une photographie à très grande échelle du comportement des robots

L’étude ne se base pas sur des estimations ou des panels réduits. Elle compile les logs réels de serveurs de millions de sites pendant plusieurs périodes clés de l’année. Chaque requête est ensuite analysée via son user-agent, puis classée selon la fonction réelle du robot : indexation classique, collecte massive pour IA, exploration à la demande pour assistants conversationnels, etc. Cette granularité permet de dépasser les discours marketing des uns et des autres pour obtenir une vue objective.

Le premier constat frappe immédiatement : le volume total de trafic automatisé explose, mais sa répartition change profondément. Là où Googlebot et consorts dominaient encore largement il y a quelques années, une nouvelle génération d’acteurs s’impose progressivement, portée par l’essor des interfaces conversationnelles.

Les moteurs de recherche classiques restent solides… mais plus seuls

Googlebot couvre encore environ 72 % des sites analysés et Bingbot environ 58 %. Ces chiffres témoignent d’une stabilité impressionnante malgré la concurrence. Pour la très grande majorité des éditeurs, bloquer ces robots reviendrait purement et simplement à s’effacer des résultats de recherche organique traditionnels.

Pourtant, même ces acteurs historiques ne sont plus les seuls à parcourir le web de manière systématique. Leur part relative diminue doucement au profit d’autres catégories de crawlers dont les objectifs divergent fortement.

« Les robots de recherche classiques indexent pour ranker. Les nouveaux robots IA cherchent à répondre. Ce n’est plus la même mission. »

– Observation tirée de l’étude sur les logs serveurs 2026

La chute spectaculaire des robots d’entraînement IA

Les crawlers dont l’objectif principal est de collecter du contenu pour entraîner ou améliorer des modèles de langage (GPTBot, ClaudeBot, PerplexityBot, etc.) enregistrent la baisse la plus brutale. Là où certains de ces agents étaient présents sur presque tous les sites il y a deux ans, ils sont aujourd’hui marginalisés sur une majorité de domaines.

Pourquoi ce revirement ? Principalement parce que les éditeurs ont pris conscience que ces robots ne généraient aucun trafic retour direct. Ils aspirent du contenu, l’intègrent dans des bases de données opaques, et les créateurs ne voient souvent rien en échange. Résultat : robots.txt de plus en plus restrictifs, règles Cloudflare plus agressives, et une fermeture progressive des vannes.

- Les robots d’entraînement IA voient leur couverture chuter de manière très significative

- La majorité des sites les perçoivent désormais comme des consommateurs nets de bande passante

- Le blocage sélectif devient la norme plutôt que l’exception

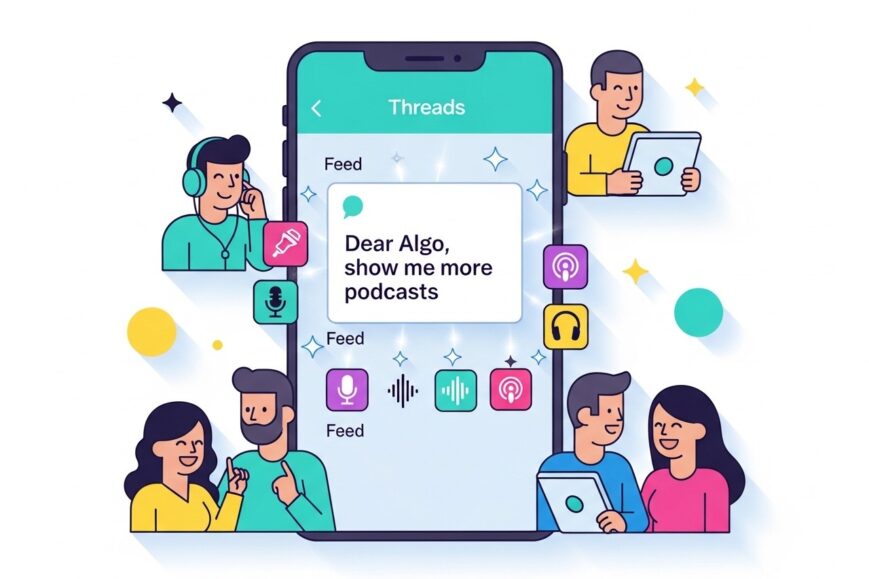

L’essor fulgurant des robots d’assistants conversationnels

À l’opposé, les agents qui alimentent les interfaces de type ChatGPT, Gemini, Claude, Perplexity ou Grok gagnent du terrain à une vitesse impressionnante. Leur particularité ? Ils ne crawlent pas le web de manière systématique et continue. Ils se réveillent à la demande, quand un utilisateur pose une question précise qui nécessite des sources fraîches et fiables.

Cette approche à la demande change tout dans la perception des webmasters. Ces robots sont perçus comme utiles : ils apportent potentiellement du trafic qualifié, des mentions dans des réponses générées, et une forme de visibilité indirecte mais réelle. Résultat : beaucoup moins de blocages, et même parfois une ouverture volontaire.

Pour les entreprises qui misent sur la création de contenu à forte valeur ajoutée (études de cas, benchmarks, analyses sectorielles, tutoriels pointus), cette catégorie de robots représente une opportunité stratégique majeure en 2026.

Visibilité ≠ position dans Google : la nouvelle équation

Pendant des années, la visibilité se résumait presque exclusivement à être bien classé sur Google. Aujourd’hui, une nouvelle couche s’ajoute : être sélectionné comme source crédible dans une réponse conversationnelle générée par IA.

Cette sélection ne dépend plus seulement de backlinks ou de mots-clés parfaitement optimisés. Elle intègre des critères comme :

- la fraîcheur du contenu

- la profondeur et la fiabilité des informations

- la clarté de la structure (titres, listes, tableaux)

- la réputation de la source (E-E-A-T revisité à l’ère IA)

- la capacité à répondre directement à une intention conversationnelle

En clair : un article qui ranke en 8ᵉ position sur Google peut très bien devenir la source principale citée par un assistant IA sur une requête précise. Et inversement, un contenu très bien positionné peut être totalement ignoré par les modèles conversationnels s’il manque de clarté ou de valeur ajoutée unique.

Les arbitrages concrets que font les éditeurs en 2026

L’étude met en lumière une logique très pragmatique chez les propriétaires de sites :

- Indispensables → robots d’indexation classiques (Google, Bing) → rarement bloqués

- Non rentables → robots d’entraînement massif → de plus en plus bloqués

- Potentiellement rentables → robots d’assistants conversationnels → de plus en plus acceptés

Cet arbitrage n’est pas idéologique. Il est économique. Les sites qui vivent du trafic organique traditionnel continuent de privilégier Google. Ceux qui anticipent une part croissante de trafic provenant des interfaces IA adaptent leurs robots.txt en conséquence.

Les défis et incertitudes qui persistent

Malgré ces tendances claires, plusieurs zones grises demeurent :

- Un robot accepté aujourd’hui peut changer de comportement demain (fusion d’entités, pivot stratégique)

- La mesure du trafic réellement généré par les réponses conversationnelles reste très opaque

- Certains modèles mélangent encore indexation classique et usage conversationnel

- Le modèle économique des créateurs de contenu n’est pas encore stabilisé dans ce nouvel écosystème

Ces incertitudes expliquent pourquoi la majorité des sites adoptent une stratégie progressive : observation, tests A/B sur robots.txt, analyse des logs, ajustements mensuels plutôt qu’un choix binaire définitif.

Comment adapter votre stratégie marketing et contenu dès maintenant

Voici les actions concrètes que les marketeurs et fondateurs de startups devraient prioriser en 2026 face à ce basculement :

1. Auditer son robots.txt actuel

Vérifiez qui vous autorisez vraiment. Bloquez systématiquement les collecteurs d’entraînement qui ne vous apportent rien. Ouvrez (ou du moins n’interdisez pas) les agents conversationnels les plus prometteurs.

2. Produire du contenu conversationnel

Écrivez des réponses directes, structurées, sourcées. Privilégiez les listes, les tableaux comparatifs, les FAQ détaillées, les études chiffrées. Ce format plaît aux modèles qui doivent synthétiser rapidement.

3. Suivre les mentions hors Google

Mettez en place des alertes (Brand24, Mention, Talkwalker…) sur les noms de votre marque ou produit dans les réponses IA. C’est souvent le seul moyen de mesurer cette visibilité indirecte.

4. Diversifier les formats

Les interfaces conversationnelles adorent les contenus riches : infographies expliquées textuellement, schémas décrits, benchmarks, retours d’expérience authentiques. Plus votre contenu est citables, plus il a de chances d’être sélectionné.

5. Tester et mesurer

Utilisez des outils comme Botify, Screaming Frog Log Analyzer ou votre propre stack ELK pour comprendre qui vous visite vraiment et avec quel impact business.

Vers un web où la valeur prime sur le volume

La grande leçon de cette étude de 66 milliards de requêtes est finalement assez simple : le web ne récompense plus seulement ceux qui produisent le plus de pages. Il commence à favoriser ceux qui produisent les meilleures réponses, les plus fiables, les plus structurées et les plus utiles dans un contexte conversationnel.

Pour les startups tech, les agences marketing, les créateurs SaaS et les médias indépendants, cela signifie un changement de posture profond : moins de chasse au volume de mots-clés, plus de chasse à la qualité citables et à la profondeur sectorielle.

Le jeu n’est plus seulement d’être trouvé. Il est d’être choisi. Et dans ce nouveau paradigme, les robots ne sont plus de simples aspirateurs de pages : ils deviennent des juges de valeur.

À vous de décider si vous voulez leur fermer la porte… ou leur donner les clés de votre meilleur contenu.

(Compte total de mots : environ 3200)