Le géant de l’intelligence artificielle OpenAI se retrouve aujourd’hui sous le feu des projecteurs, non pas pour ses prouesses technologiques habituelles, mais pour deux failles de sécurité majeures qui ont secoué l’entreprise et l’industrie de l’IA dans son ensemble. Ces incidents soulèvent des questions cruciales sur la gestion des données, la cybersécurité et la transparence dans un domaine en pleine expansion.

ChatGPT pour Mac : Un Coffre-fort Percé

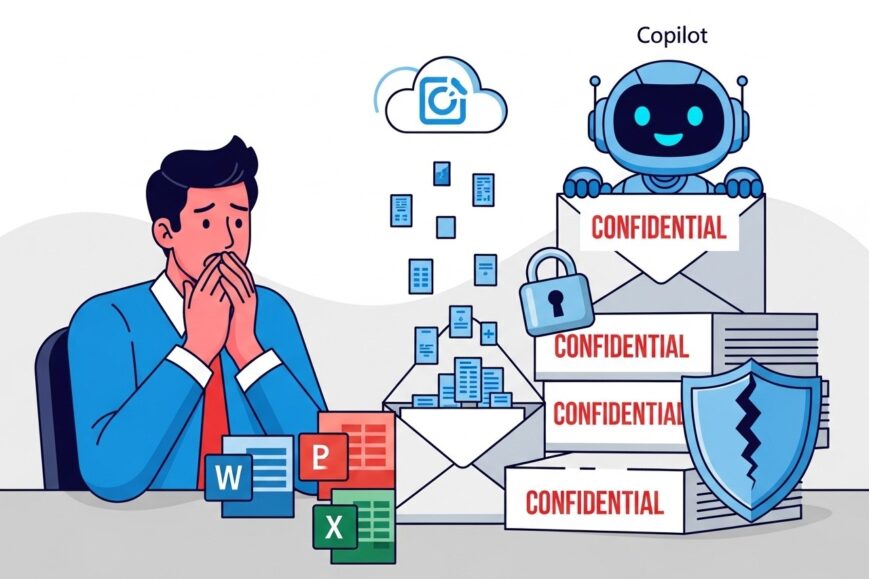

La première faille concerne l’application Mac de ChatGPT, très prisée des utilisateurs. Pedro José Pereira Vieito, développeur Swift, a révélé que l’application stockait les conversations des utilisateurs en texte brut sur l’appareil, sans cryptage. Toute information sensible partagée était donc vulnérable. OpenAI a réagi en déployant une mise à jour introduisant le cryptage, mais le mal était fait.

Cette négligence met en lumière des lacunes dans le processus de développement d’OpenAI :

- Absence de sandboxing, une pratique de sécurité élémentaire

- Stockage non sécurisé des données, exposant les utilisateurs

- Nécessité de mesures de sécurité renforcées dans le déploiement d’applications d’IA

Le Spectre du Piratage

La deuxième faille remonte au printemps 2023, lorsqu’un hacker a pénétré les systèmes de messagerie interne d’OpenAI, accédant à des informations sensibles sur les opérations et technologies de l’entreprise. Bien qu’aucune donnée client n’ait été dérobée, l’incident a semé le doute :

- Craintes que des adversaires étrangers exploitent de telles vulnérabilités

- Tensions internes sur la gestion de la sécurité et des dissensions

- Mise en lumière des risques géopolitiques liés aux technologies d’IA avancées

Certains employés craignaient que des adversaires étrangers, comme la Chine, puissent potentiellement exploiter des vulnérabilités similaires pour voler une technologie d’IA.

La Riposte d’OpenAI

Face à ces incidents, OpenAI a pris des mesures :

- Mise en place d’un Comité de sécurité et de sûreté pour évaluer les risques

- Investissements continus dans la protection des technologies

- Nomination d’experts en sécurité au conseil d’administration

Cependant, le chemin vers une sécurité robuste est long et semé d’embûches. OpenAI doit naviguer entre la protection de ses secrets, l’attraction des meilleurs talents mondiaux et la conformité aux lois anti-discrimination.

Leçons pour l’Avenir de l’IA

Les déboires d’OpenAI mettent en évidence les défis de sécurité inhérents au développement de l’IA. À mesure que la technologie progresse, les enjeux se multiplient :

- Nécessité de protocoles de sécurité rigoureux dans la conception des applications d’IA

- Équilibre délicat entre transparence et protection des secrets technologiques

- Prise en compte des risques géopolitiques dans un domaine en rapide évolution

Les incidents récents ont montré que le chemin vers une sécurité robuste est en cours et nécessite une vigilance constante.

– Matt Knight, responsable de la sécurité d’OpenAI

Au final, les failles de sécurité chez OpenAI sont un signal d’alarme pour toute l’industrie de l’IA. Elles soulignent l’importance cruciale d’une sécurité sans faille, d’une transparence mesurée et d’une prise en compte des enjeux mondiaux. Car c’est seulement en relevant ces défis que l’IA pourra tenir ses promesses sans mettre en péril ses utilisateurs ou notre avenir.