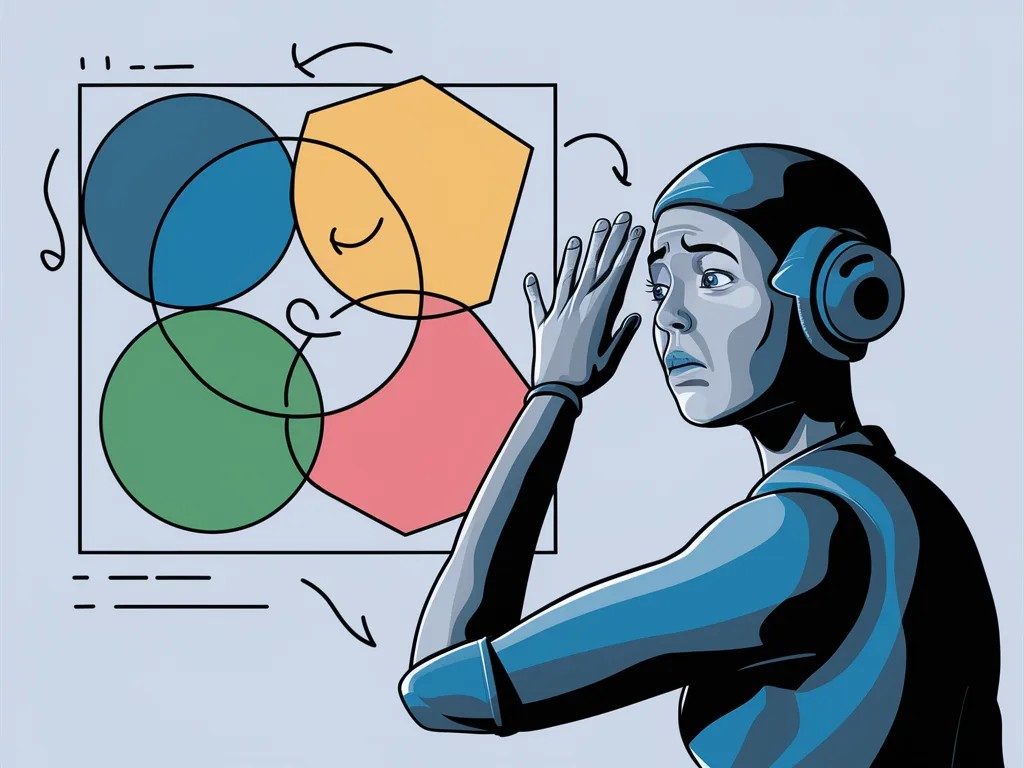

Imaginez demander à un enfant de compter le nombre de cercles qui s’entrelacent dans une image. Facile, n’est-ce pas ? Pourtant, cette tâche apparemment simple s’avère être un véritable défi pour les tout derniers modèles d’intelligence artificielle dits « multimodaux », capables de comprendre à la fois le texte, l’audio et les images.

Les géants de la tech ne cessent de vanter les prouesses de leurs IA dernier cri comme GPT-4o ou Gemini 1.5 Pro, mettant en avant leurs capacités de « compréhension visuelle ». Cependant, une récente étude menée par des chercheurs des universités d’Auburn et d’Alberta vient jeter un pavé dans la mare. Leurs travaux suggèrent que ces IA ne « voient » peut-être pas du tout comme on pourrait l’imaginer.

Des tâches visuelles élémentaires qui mettent l’IA en échec

Les chercheurs ont soumis les modèles d’IA les plus avancés à une série de tests visuels très simples. Par exemple, déterminer si deux formes se chevauchent, compter le nombre de pentagones dans une image ou encore identifier quelle lettre est entourée dans un mot. Des exercices qu’un enfant réussirait sans peine, mais qui se sont avérés particulièrement ardus pour ces IA pourtant si sophistiquées.

Prenons le test de chevauchement de formes. Lorsque deux cercles sont clairement séparés, GPT-4o obtient un taux de réussite supérieur à 95%. Mais dès que la distance se réduit, sa performance chute à 18% ! Gemini Pro 1.5 s’en sort un peu mieux, avec 70% de bonnes réponses, mais cela reste loin d’être parfait.

Compter les cercles, un casse-tête pour l’IA

L’expérience de comptage des cercles entrelacés est encore plus révélatrice. Face à cinq anneaux olympiques, tous les modèles testés répondent correctement à 100%. Mais il suffit d’ajouter un seul anneau pour que leurs performances s’effondrent ! Gemini est complètement perdu et ne donne plus aucune bonne réponse. Sonnet-3.5 ne fait guère mieux avec seulement un tiers de réponses correctes. Quant à GPT-4o, il atteint péniblement les 50%.

Nos sept tâches sont extrêmement simples, et les humains obtiendraient une précision de 100%. Nous nous attendons à ce que les IA fassent de même, mais elles en sont actuellement INCAPABLES.

– Anh Nguyen, co-auteur de l’étude

L’IA ne voit pas, elle reconnaît des motifs

Comment expliquer ces étonnantes lacunes ? Selon les chercheurs, cela montre que les modèles d’IA ne « voient » pas réellement au sens où on l’entend. Ils fonctionnent en associant des schémas de leurs données d’entraînement aux informations qu’on leur soumet. C’est ce qui leur permet d’être si performants sur des tâches spécifiques pour lesquelles ils ont été entraînés, comme reconnaître des objets du quotidien ou analyser des expressions faciales.

Mais dès qu’on sort de ce cadre, leurs capacités de raisonnement visuel montrent vite leurs limites. Un peu comme si on leur décrivait une image sans réellement leur montrer. Ils peuvent faire des suppositions plausibles, mais sont incapables d’analyser ce qu’ils ont réellement sous les yeux.

Vers une meilleure compréhension des capacités de l’IA

Cette étude a le mérite de nuancer le discours marketing des géants de la tech, qui ont parfois tendance à surestimer les prouesses de leurs IA. Elle nous rappelle que malgré des progrès fulgurants, ces systèmes ont encore de nombreuses limites. Surtout, elle souligne l’importance de mieux comprendre leur fonctionnement, au-delà des effets d’annonce.

Car si ces IA sont capables de prouesses dans leur domaine de prédilection, elles sont encore loin de l’intelligence visuelle humaine. Tirer des conclusions hâtives sur leurs capacités pourrait nous induire en erreur et susciter des attentes irréalistes. Un constat qui appelle à la prudence et à approfondir les recherches sur les mécanismes à l’œuvre dans ces systèmes complexes.

L’avenir de l’IA visuelle

Malgré ces résultats mitigés, les modèles d’IA dits « multimodaux » ont un potentiel immense. Nul doute que les efforts de recherche permettront d’améliorer leurs performances et de combler peu à peu le fossé qui les sépare encore de la cognition humaine. À terme, on peut imaginer des IA capables d’analyser et d’interpréter le monde visuel avec une finesse proche de la nôtre.

Les applications potentielles sont innombrables, de la conduite autonome à l’analyse médicale en passant par la reconnaissance faciale ou la réalité augmentée. Mais pour y parvenir, il faudra sans doute repenser en profondeur les architectures et les méthodes d’apprentissage de ces systèmes. Un défi passionnant pour la communauté scientifique, qui devra aussi se pencher sur les questions éthiques soulevées par ces technologies.

Une chose est sûre : la compréhension du monde visuel par l’IA n’en est qu’à ses balbutiements. Les prochaines années s’annoncent riches en découvertes et en innovations dans ce domaine en pleine effervescence. De quoi nous faire entrevoir un futur où hommes et machines pourraient enfin partager une même vision du monde, aussi complexe et nuancée soit-elle. La route est encore longue, mais le jeu en vaut assurément la chandelle.